Cette série d'articles est liée à une présentation faite à la GameSoundCon en octobre 2020. L'objectif de cette présentation était de fournir une perspective et des outils aux créateurs pour affiner leur prochain projet en utilisant des techniques de rendu audio à base d'objet. Ces techniques visent à reproduire la spatialisation du son la plus proche possible de celle que nous percevons dans la nature.

Ce contenu a été divisé en trois parties :

- La première partie, couverte par cet article, expose les professionnels de l'audio aux avantages d'utiliser l'audio à base d'objet pour leurs prochains projets, par opposition à l'audio à base de canaux, en montrant comment cette approche peut donner de meilleurs résultats pour une pluralité de systèmes et de périphériques de lecture.

- La deuxième partie expliquera comment la version 2021.1 de Wwise a évolué pour offrir un environnement de création complet qui exploite pleinement les objets audio tout en améliorant le flux de travail pour toutes les considérations de mixage.

- Enfin, la troisième partie partagera une série de méthodes, techniques et astuces qui ont été employées par des concepteurs sonores et des compositeurs utilisant des objets audio sur des projets récents.

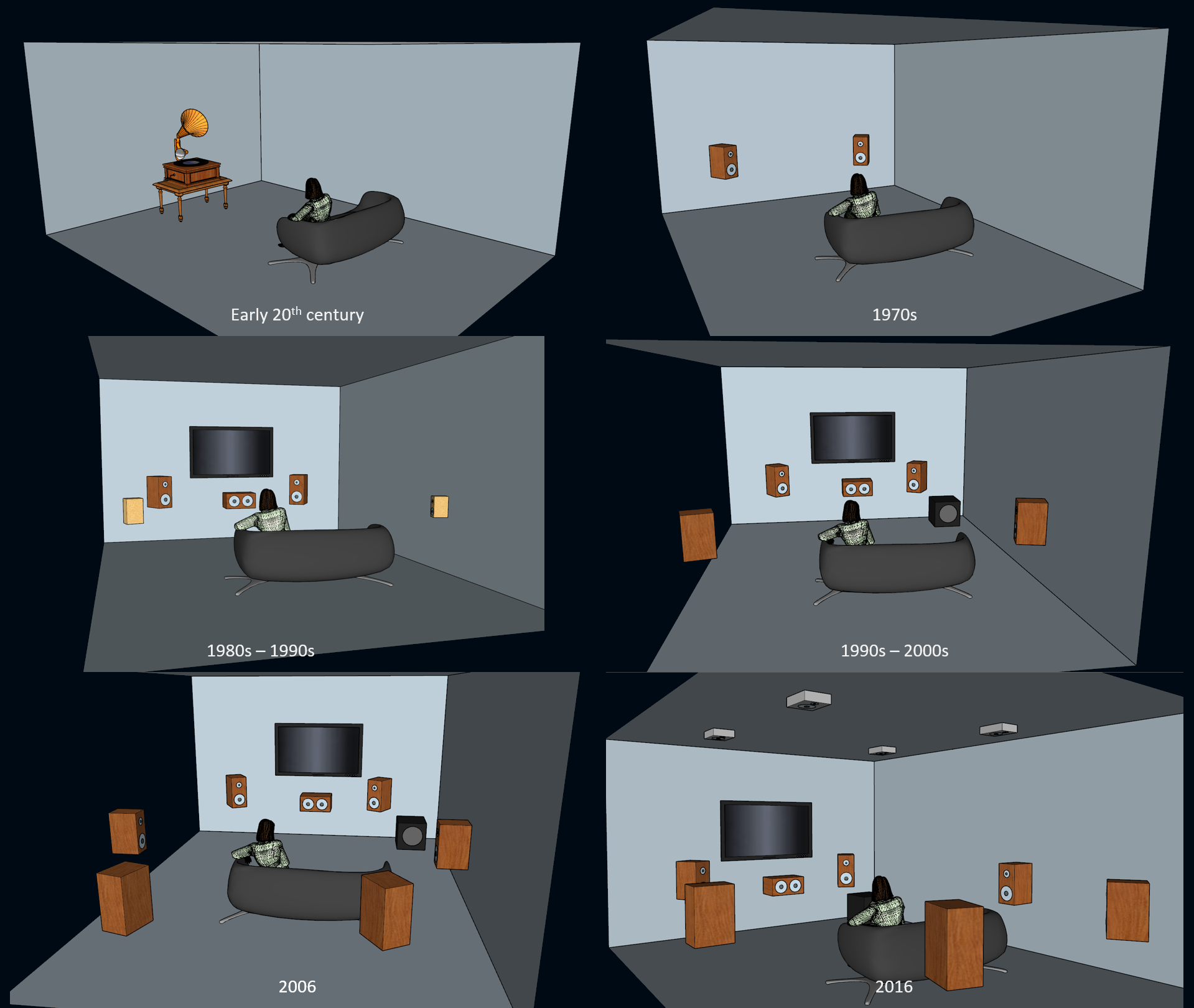

Encoder la spatialisation - aperçu historique

La pratique de l'enregistrement audio sur support en vue d'une restitution existe depuis plus d'un siècle. Pendant plusieurs décennies, cette capture était effectuée en mono, ce qui, de par sa nature même, ne permettait pas de spatialisation (bien que certains puissent affirmer que les enregistrements mono peuvent facilement capturer une sensation de profondeur, ce qui est en soi une forme de spatialisation). Ce n'est que dans les années 1970, avec l'adoption massive des systèmes stéréo, qu'une reproduction de la musique avec spatialisation est devenue accessible au public. Avec l'adoption générale du format stéréo, les ingénieurs du son et les mélomanes ont commencé à mixer pour et à parler de spatialisation et de directionnalité du son.

Plus tard, dans les années 1980, avec l'adoption généralisée des magnétoscopes et la possibilité de louer des films sur cassettes VHS (Video Home System), l'industrie s'est rassemblée autour de l'idée de faire entrer dans le cadre domestique l'expérience des salles de cinéma... à condition que le grand public achète de nouveaux systèmes son ! C'est ainsi que l'industrie est passée de la configuration LCRS (Gauche-Centre-Droit-Surround) à des configurations de haut-parleurs en 5.1 offrant une dynamique et une gamme de fréquences complète, puis à la configuration 7.1, et maintenant à la configuration 7.1.4 avec l'ajout de canaux de hauteur.

Évolution des systèmes audio spatialisés sur le marché grand public

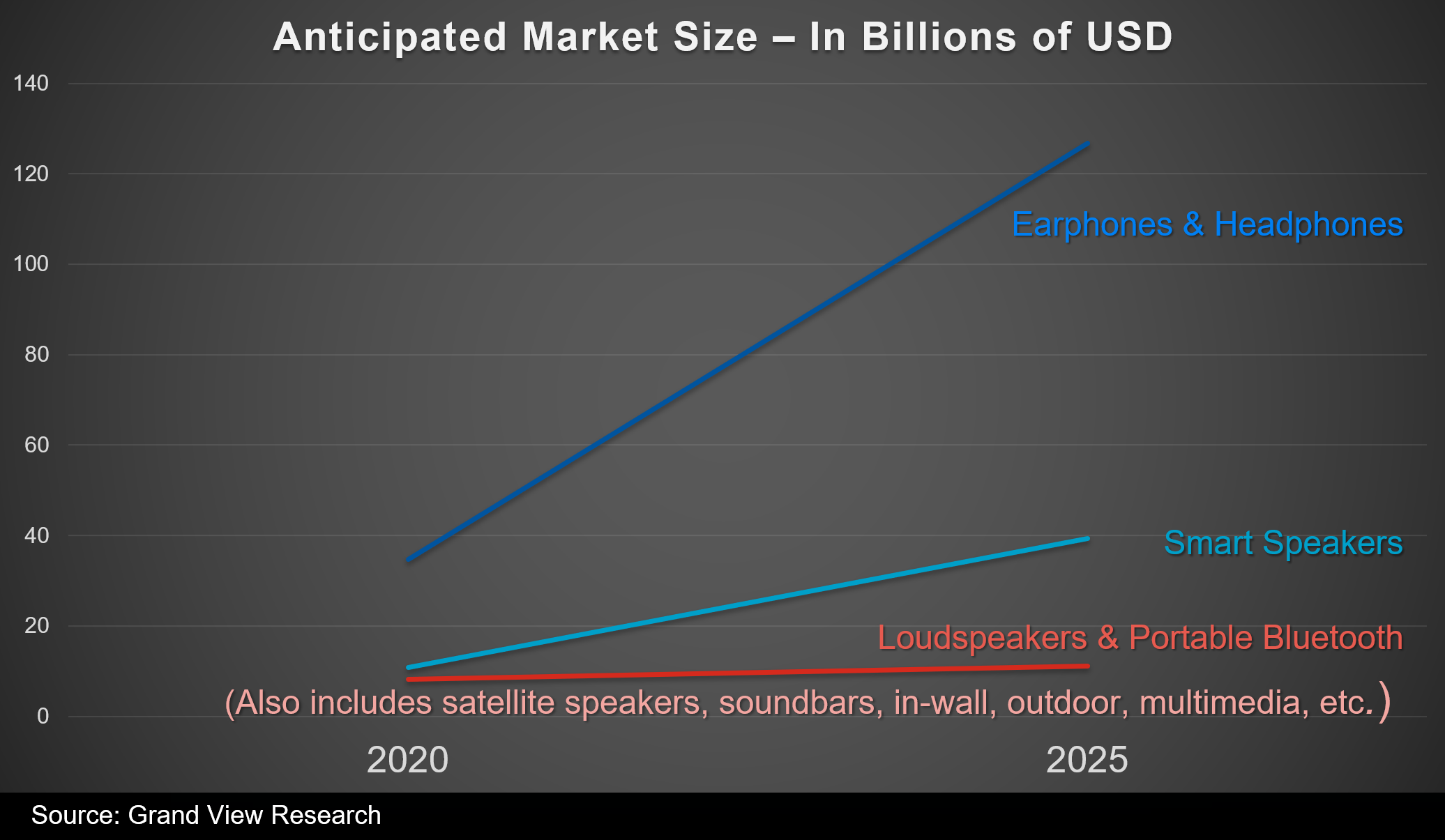

Cela dit, au cours de la dernière décennie, le mode de vie standard a évolué au profit de la mobilité et l'idée d'ajouter des haut-parleurs supplémentaires dans le salon fait progressivement place à une utilisation accrue des écouteurs. L'omniprésence des jeux mobiles et multijoueurs a certainement contribué à cette évolution. Si l'on examine les tendances des ventes de haut-parleurs par rapport aux ventes d'écouteurs et les projections du marché pour les années à venir, tout porte à croire que les gens continueront dans le futur à jouer à des jeux au casque.

Domination des écouteurs et des casques sur les haut-parleurs dans les projections de ventes sur les cinq prochaines années

Percevoir l'audio dans l'espace

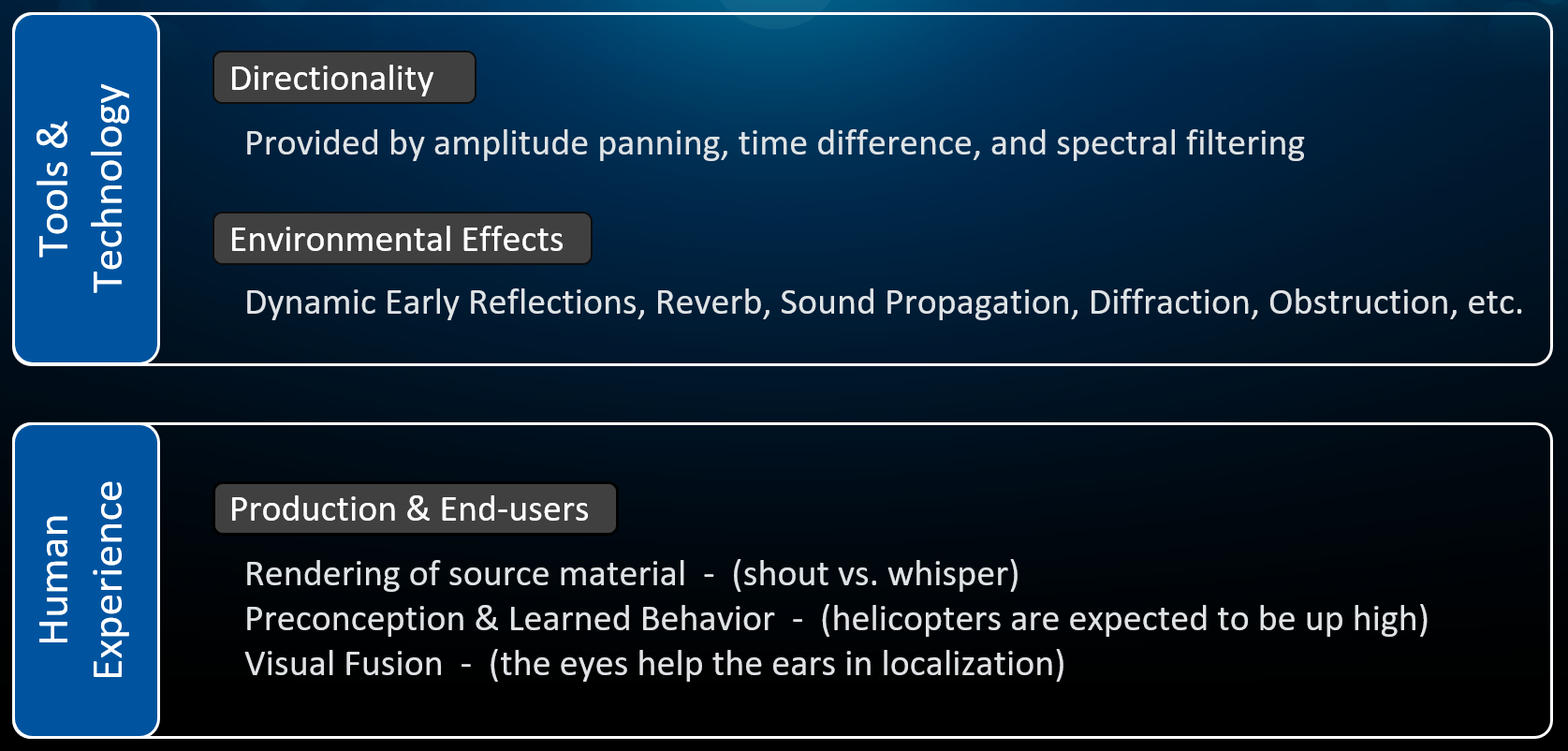

Pour offrir des expériences réalistes avec de l'audio restitué sur des haut-parleurs ou des casques, deux facteurs doivent coexister et se compléter :

- Outils et Technologie : la technologie de restitution audio doit simuler aussi précisément que possible la physique du son.

- Expérience Humaine : la performance audio doit correspondre à nos attentes en tant qu'êtres humains.

Examinons ces deux facteurs plus en détail.

La technologie et notre expérience en tant qu'êtres humains sont les deux facteurs en jeu dans notre capacité à percevoir un son restitué dans l'espace de la même manière que dans la nature.

Restitution de la directionnalité

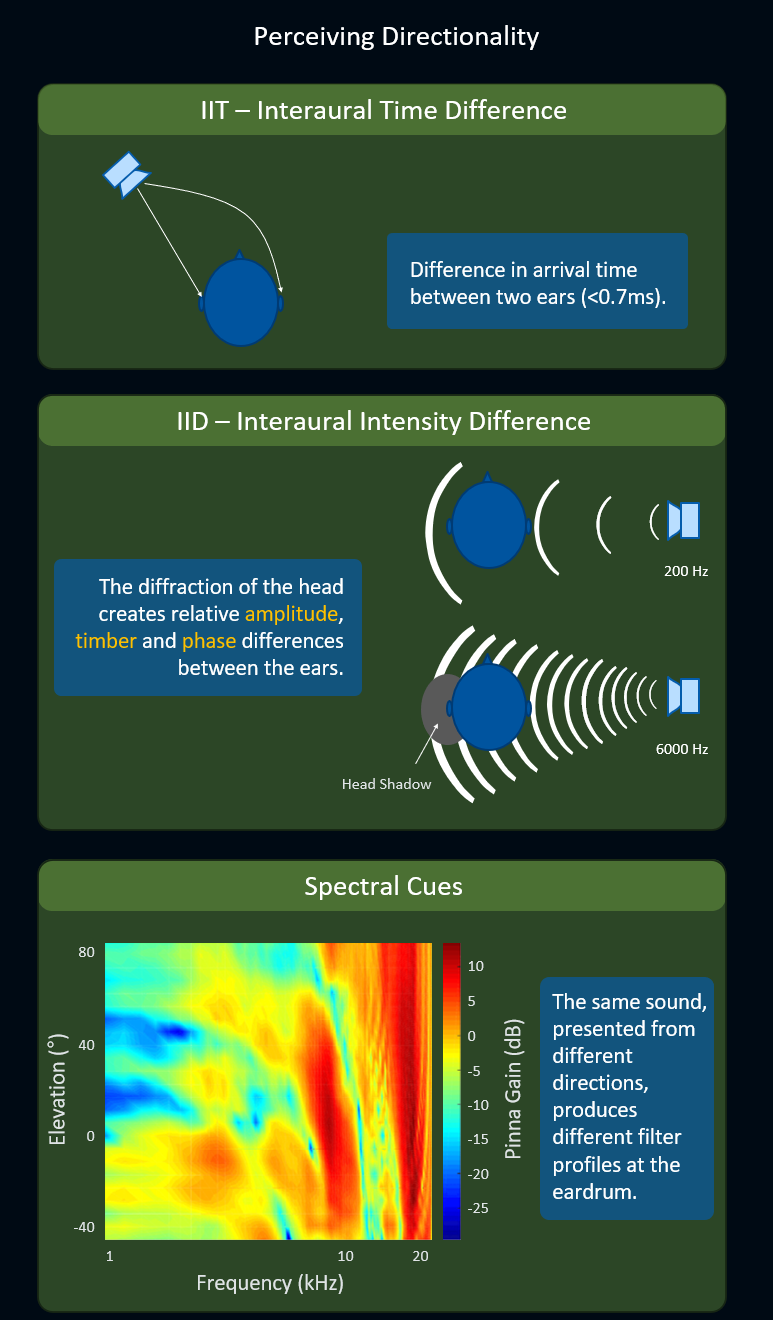

La fonction de transfert liée à la tête (HRTF ou « Head-Related Transfer Function ») est généralement la meilleure technologie disponible lorsqu'un haut niveau de précision de la directionnalité du son au casque est nécessaire. Afin de restituer la directionnalité du son avec précision, les algorithmes HRTF exploitent les éléments perceptifs suivants :

- ITD (« Interaural Time Difference » ou Différence de Temps Interaurale) : Représente la différence de temps d'arrivée d'un même son entre deux oreilles. La différence de temps n'est même pas d'une milliseconde, mais elle est suffisante pour que le cerveau perçoive la directionnalité.

- IID (« Interaural Intensity Difference » ou Différence d'Intensité Interaurale) : Représente l'effet d'obstruction de la tête sur l'une des deux oreilles, ce qui crée des différences relatives d'amplitude, de timbre et de phase entre les deux oreilles. Cet effet est plus ou moins prononcé selon la fréquence du signal.

- Indices Spectraux : Représentent les différentes configurations, au niveau du tympan, des pics et des creux fréquentiels d'un même son émis depuis différentes directions.

Utilisation des procédés d'ITD, IID et indices spectraux pour améliorer la précision des sons spatialisés autour de l'auditeur. Cet article illustre bien la façon dont la fonction HRTF est mesurée.

Reproduction des effets d'environnement

Les autres aspects qui peuvent être reproduits par la technologie sont les effets de l'environnement, tels que l'atténuation avec la distance, la dynamique des premières réflexions, la réverbération tardive, la propagation du son, la diffraction et l'obstruction. Plus ces phénomènes sont sollicités, plus le cerveau reçoit d'informations pour mieux percevoir les sons dans l'espace. Remarquez que nous pourrions en dire beaucoup plus sur la contribution des effets de l'environnement à la spatialisation 3D, mais cet article se concentre sur les avantages de l'utilisation d'objets audio par rapport à l'audio à base de canaux.

Le facteur de l'expérience humaine

L'autre facteur qui affecte notre capacité à localiser un son dans l'espace ne repose pas sur la technologie, mais sur trois aspects de notre expérience en tant qu'êtres humains.

Le premier aspect concerne le « rendu du matériau source » : si vous entendez quelqu'un chuchoter par exemple, cette personne est probablement proche, certainement beaucoup plus proche que si vous entendiez la même phrase criée très fort.

Le deuxième aspect concerne les « idées préconçues et les comportements acquis » : en tant qu'êtres humains, nous nous attendons à ce que certains sons, comme un hélicoptère ou un avion par exemple, proviennent d'au-dessus de notre tête. C'est quelque chose que nous apprenons avec le temps, au fur et à mesure que nous grandissons.

Enfin, le troisième aspect concerne la « fusion visuelle », où nos yeux aident nos oreilles à localiser précisément les sons émis dans l'espace 3D. Par exemple, si vous entendez un son provenant de l'extérieur de votre champ de vision, vous serez capable de deviner qu'il se trouve quelque part sur votre côté gauche, mais ce n'est qu'après avoir bougé votre tête pour trouver avec vos yeux l'émetteur du son que vous saurez précisément où se trouve cet objet dans l'espace.

Cette section sur la façon dont l'expérience humaine participe à notre capacité à percevoir le son dans l'espace a été traitée en détail par Brian Schmidt dans sa brillante conférence « Technology's Impact on Creativity, Case Study: Beyond HRTF » présentée au MIGS 2017.

Audio à base de canaux

Maintenant que nous avons clarifié comment nous percevons le son dans l'espace et comment la technologie peut reproduire certains des indices essentiels impliqués dans cette perception, voyons comment nous avons utilisé différentes configurations de canaux au fil des ans pour encoder la directionnalité et les effets de l'environnement sur divers supports, tels que les vinyles, les bandes magnétiques et les supports numériques, mais aussi avec des applications temps réel, comme Wwise.

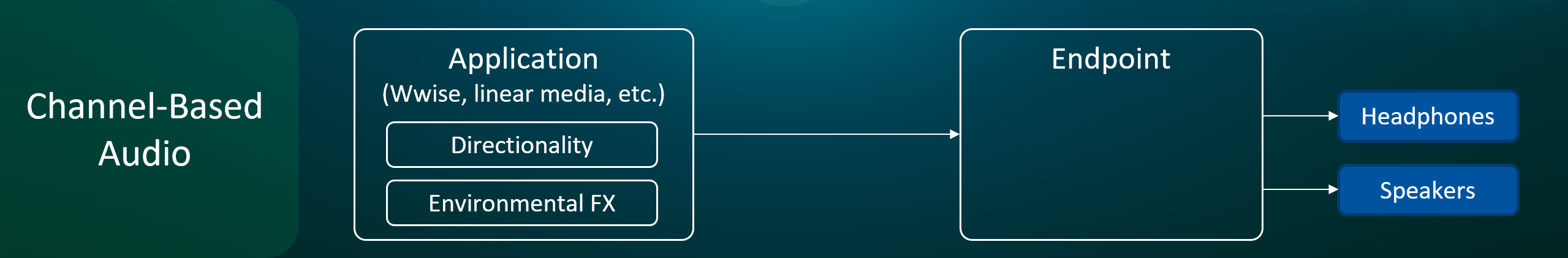

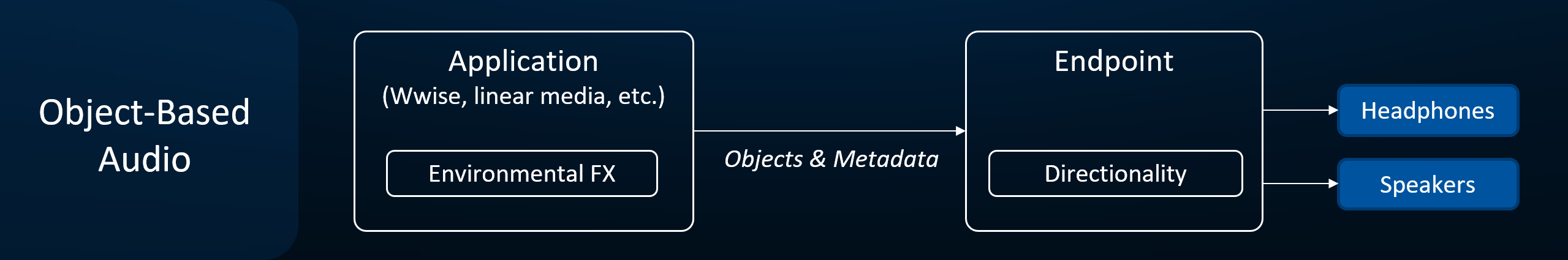

Avec les formats audio basés sur les canaux, la directionnalité et les effets de l'environnement sont encodés par l'application.

S'appuyer sur les formats audio basés sur les canaux pour encoder la spatialisation était une solution pratique compte tenu de la technologie et des ressources informatiques disponibles à l'époque. Cependant, cette approche comporte de multiples défauts lorsqu'une meilleure précision spatiale est requise. Les faiblesses typiquement rencontrées sont des éléments comme les angles inégaux entre les positions des canaux, ce qui provoquent une distorsion de l'image sonore et des creux d'amplitude, les problèmes de phase avec les sons en mouvement rapide, et les configurations qui ne peuvent reproduire le son que sur une surface plane ou hémisphérique. Cela exclut également la réalité du consommateur pour qui des haut-parleurs peuvent manquer, être mal placés, câblés hors phase, etc.

Il est intéressant de noter qu'aucun des défauts mentionnés ci-dessus ne s'applique au système ambisonique, bien qu'il s'agisse techniquement d'un format basé sur les canaux. L'ambisonique utilise des canaux audio pour encoder une représentation sphérique d'une scène sonore, et plus le nombre de canaux utilisés est important, plus la scène sonore sera précise. Les articles suivants fournissent un bon aperçu du format ambisonique, et de la manière dont il peut être utilisé comme représentation spatiale intermédiaire.

Quelle est le point de terminaison ?

Nous utilisons le terme « point de terminaison » pour désigner le périphérique système (par exemple, la section en charge de l'audio au niveau du système d'exploitation de la plate-forme) qui est responsable du traitement final et du mixage du signal audio qui sera envoyé aux écouteurs ou aux haut-parleurs.

À l'initialisation du jeu, Wwise est informé de la configuration audio du point de terminaison (par exemple 2.0, 5.1, Windows Sonic for Headphones, et PS5 3D Audio) afin d'effectuer un rendu audio dans le format attendu par le point de terminaison.

L'avènement des objets audio

Pendant longtemps, la norme d'excellence pour les ingénieurs du son qui mixaient de l'audio linéaire ou non linéaire était de travailler dans un environnement contrôlé et d'utiliser des haut-parleurs de haute qualité sur le plus grand nombre de canaux audio disponibles à l'époque (5.1, 7.1, etc.). Cette méthodologie garantissait que toute réduction à un nombre inférieur de canaux fournirait toujours un mixage cohérent et une intelligibilité des dialogues à travers la pluralité d'environnements d'écoute au niveau du consommateur. Cette approche, bien que fonctionnelle, manque cependant de précision spatiale en raison des limitations inhérentes à l'encodage de la spatialisation en utilisant des formats basés sur les canaux, comme indiqué précédemment dans cet article.

Une approche préférable pour offrir une meilleure spatialisation à l'utilisateur consiste à déléguer l'encodage de la directionnalité au point de terminaison. Le point de terminaison est dans une bien meilleure position pour savoir précisément comment l'utilisateur écoute le contenu audio, puisque la configuration a été définie par l'utilisateur, ou par la connexion avec les autres appareils de la chaîne audio (par exemple l'amplificateur de salon, le téléviseur, la barre de son). Par conséquent, le point de terminaison peut utiliser la méthode de rendu la plus appropriée pour diffuser le mixage final sur des écouteurs ou des haut-parleurs.

Avec le format audio basé sur les objets, la responsabilité de l'encodage de la directionnalité est transférée au point de terminaison.

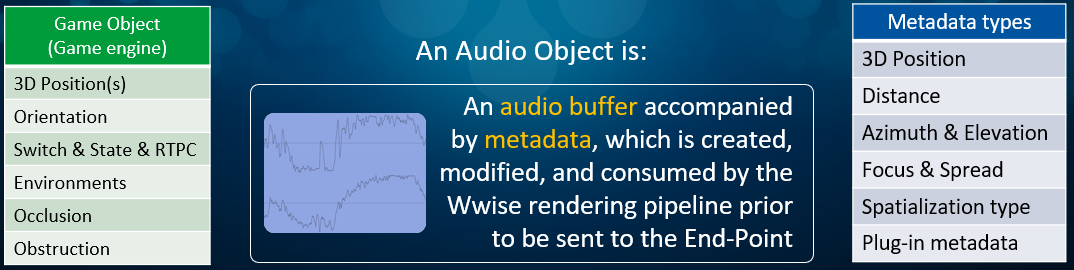

Pour obtenir le meilleur rendu de directionnalité possible, l'application doit fournir au point de terminaison un ensemble d'informations complet, qui prend la forme d'une série d'objets audio et de leurs métadonnées associées. Plus précisément, un objet audio représente la combinaison d'un tampon audio et de ses métadonnées, qui est créée et modifiée par le processus de rendu de Wwise avant d'être envoyée au point de terminaison. Les types de métadonnées attachées aux objets sont générés par Wwise et sont en lien avec l'information du signal audio et des plug-ins (tableau bleu du schéma ci-dessous). Ces informations ne doivent pas être confondues avec le type d'informations contenues par les Game Object du moteur de jeu (tableau vert).

Types de métadonnées fournies avec les objets audio (tableau bleu) par rapport aux informations fournies par les Game Object (tableau vert).

Conclusion

Cet article met en évidence les avantages que présente l'audio à base d'objet en ce qui concerne la qualité et la précision de la spatialisation telle qu'elle est exécutée par le périphérique audio de l'utilisateur, lequel peut être unique pour chaque utilisateur. Cette nouvelle approche, tout en offrant une spatialisation sonore beaucoup plus naturelle, permet de prendre en compte des considérations supplémentaires au moment de la conception sonore. Ces perspectives seront abordées dans le prochain article de cette série en trois parties.

Commentaires