このシリーズでは、従来、現在、そして最新のリバーブテクニックを、没入感とスペーシャル(空間)化の観点から幅広く見ていきます。前回までの記事で、リバーブで表現する没入感とVR(バーチャルリアリティ)の関係を探り、従来のリバーブアルゴリズムの裏にある技術を確認しました。今回は、音響シミュレーションの最近の傾向と、スペーシャルリバーブのエフェクトへの応用について考えます。

鉄板を使った音伝播の音響シミュレーション

これまで見た通り、従来のリバーブは今でも重要なテクニックですが、没入感を高める手段を改めて探る必要があるのも事実です。制作現場の新たなニーズに応えてリバーブのテクニックが進化したのと同様に、音が鳴り響くバーチャル空間を表現しようと、VRの需要から技術革新が推し進められています。

バイノーラルアルゴリズムのおかげで、近づいてくる音の方向性をヘッドフォンで明確に感じ取れるようになりました。バイノーラルアルゴリズムはこれからも進化を続け、近い将来、個人に合わせて算出されるようなHRTF(Head Related Transfer Function、頭部伝達関数)フィルターが開発されるでしょう。それと同時に、直接音後のリバーブエフェクトもスペーシャルキューを保持できるようにする必要があります。従来のリバーブアルゴリズムは、時間と共に効率的にエコーの密度を高めますが、スペーシャルキューを表現するのに不可欠なインタラクティブ性が、その過程で失われてしまいました。これは特に、重要な知覚的情報を含むアーリーリフレクションで顕著です。この問題を克服するには、シミュレーションのアルゴリズムに仮想空間の3次元情報を取り込む必要があります。

ヘッドフォンを使うとリスナーが常にスピーカーの中央にいるため、臨場感あるオーディオエフェクトを表現しやすくなります [1]

VRサウンドの可聴化を実現するために、従来のリバーブにとらわれない様々な音の表現方法を検証します。言い替えれば、仮想空間のリバーブを聞くということです。仮想音響の可聴化とは、物理や画像の考え方を取り入れて音の伝播をシミュレーションする研究分野です。実際に、空間情報を取り込んで現実的なシミュレーションを実現するために、閉ざされた空間で音がどのように伝播するのか、そしてどうシミュレーションすべきかを、再考する必要があります。![Spatial sound is also needed for multi-channel setups, such as the SATosphere in Montreal which has 157 speakers [2]. Spatial sound is also needed for multi-channel setups, such as the SATosphere in Montreal which has 157 speakers [2].](http://info.audiokinetic.com/hubfs/Blog_Images/Benoit%20blog%202/Picture2.png)

スペーシャルサウンドには、モントリオールにある157のスピーカーが設置されたSATospherのようなマルチチャンネル設定が必要[2]

音の伝播は、非常に複雑な現象です。シミュレーションの精度を向上するには、膨大な量の演算が伴います。そこで、それぞれの方式の強みや弱み、そしてどのような知覚的な結果があるのかを、検討することが重要です。

音の伝播

我々が音として感知するのは急激な振動によって解放されるエネルギーのことで、力学的な波動が様々な媒質を伝わります。声帯などの音源の振動変異からくる運動エネルギーは、周囲の空気などの媒質の粒子に伝わります。音自体が動くのでなく、運動エネルギーが粒子から粒子へと伝わり、エネルギーを伝える媒質の粘性によって徐々に散逸するのです。

密度の濃い媒質では粒子が緊密に詰まっていて伝播が速く、重い媒質では粒子を動かすのに必要なエネルギーが大きくなる分、エネルギー散逸が増加します。また、音響インピーダンスという特性が、媒質における伝播が周波数によって変わる様子を表します。大気から壁面の媒質に伝播しないエネルギーは反射して、部屋のリバーブに貢献します。レコーディングスタジオでリバーブを減らすために繊維性の素材など低密度のものが使われるのは、このためです。媒質表面の特質によって、反射方向も変わります。ここで重要なのは、音の波長によってこのような現象は変化するので、周波数に依存する現象だということです。波長が長ければ低周波音、波長が短ければ高周波音として感じられます。

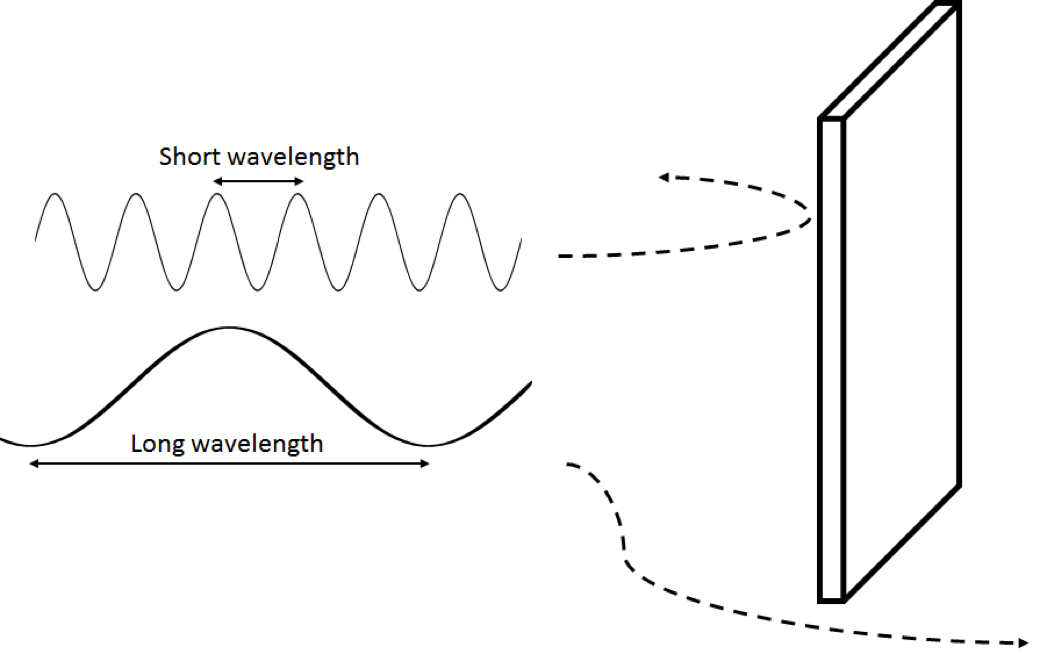

音の周波数に依存する特性は、回析という音伝播のもう一つの重要な要素を考慮すると分かりやすくなります。ゲームオーディオで回析をオブストラクションと呼びますが、これを通して音波が障害物や開口部の周りを回って音源から直線位置にないリスナーまで届きます。一般的にオブストラクションを再現するためにローパスフィルタ―を使うのは、実際の回析の特徴に基づいています。障害物より短い音波が障害物に接すると、音は反射します。ところが、障害物より長い音波は障害物を回ります。つまり、この2つの周波数を1つの信号にまとめた状態を考えると、同じ障害物に向かって伝わった場合、その壁の裏にいるリスナーには低周波(波長が長い方)だけが聞こえます。障害物の形が複雑になると、このエフェクトもややこしくなります。例えば、人間の頭を回る音の回析は非常に複雑で、耳に付けるマイクとインパルスサウンドを採用して録音する必要があります。このようにHRTFフィルターをキャプチャーしてバイノーラルエフェクトを作成します。媒質の大きさ、形状、密度、音響インピーダンス、表面材質などは全て、周波数の異なる音が空間を伝わる様子に影響する媒質の特性です。

波長が短ければ障害物に反射しやすく、長ければ回析しやすくなります。

逆に、光は全く別の方法で伝播します。光は電磁波の一種で、真空状態でも伝わります。実は、真空状態でなければ光は伝播しません。つまり媒質の粒子間を通過するのです。密度が高い媒質ほど、伝播が遅くなったり阻止されたりします。更に、目に見える光は、耳に聞こえる音より波長がかなり短めです。目で見える光の波長は400-700 nmであるのに対して、耳に聞こえる音の波長は17 mmから17mです。速度は、大気中の音速が秒速343 mであるのに対して、光は秒速 3億 m弱です。だからこそ、反響音のディレイを細かく気にしなければならないのです。このように光と音の特質が違い、様々な媒質や障害物に対する光と音の波が、特に回析などで、異なる現象を見せます。とはいえ、閉ざされた空間での回析はそれほど目立たないので、音波を表現するためにまず光の伝播を参考にするのも悪くありません。

レイベース法(Ray-based methods)

レイベース法は、光の伝播にヒントを得た音伝播のシミュレーション技術です。音が直線で伝播するとしたアプローチで、簡単な線形代数を使えば複数の壁面の位置に基づいて音の反射方向を簡単に計算できます。音速が遅いことを考慮して計算モデルにディレイを追加して、周波数によって壁への吸収が異なる点をフィルターでシミュレーションします。レイベース法では通常は形状を簡素化して処理しますが、高周波のアーリーリフレクションの音伝播を、比較的正確に素早くシミュレーションできます。実際の部屋の形状は複雑であることが多く、反射面も増えるので、エコーの密度がより豊かになります。このため、後期反響はこの方式であまり上手く再現できません。また、空間の形状が複雑になると、低周波の回析が際立つ要素となります。その場合、反射するそれぞれの光線(レイ)の進む方向が分かっていれば、別途シミュレーションできます。

レイベース法から派生した主な方式として、虚像法(image source method)とレイトレーシング(ray-tracing)の2つがあります。虚像法は、音の反射経路を壁面毎に計算します。処理を継続して、反射自体が他の壁面に反射する時の高次反射も含めることもできます。レイトリーシングでは光線が様々な方向に出され、障害物にあたると反射します。面から反射する度に、複数の新しい光線が異なる方向に出されます。壁面素材や部屋の隅などから散乱する音をシミュレーションするために、ランダムな方向を複数選択できます [4]。このアプローチは室形状が複雑な状況に有利ですが、演算量が増えます。両者とも、アーリーリフレクションを重視できるようにアルゴリズムの深度を制限できます。音源やリスナーの位置を基に各光線の正確な位置が分かるため、レイベース法で音の空間的や時間的な位置をインタラクティブに決めることができます。音伝播の距離をシミュレーションするために、大気中の音速に基づいてディレイが導入されます。

エジンバラ大学のAcoustics and Audioグループに所属するBrian Hamilton提供の以下の動画 [4] を参照してください。レイベース法を使った音源の伝播の可視化です。

レイベース法の音伝播シミュレーション

|

|

|

|

|

波動ベースモデリング(Wave-based modeling)

前述のとおり、音波の実際の伝わり方は光波と同じではありません。そこで、もっと正確に音波の伝播をシミュレーションすることを目的とした方式がいくつかあります。例えばFDTD法(Finite Difference Time Method)という数値計算法を用いて、粒子から粒子へ音エネルギーが伝わる様子をシミュレーションできます。この方式では、実際の粒子の代わりに3次元空間を一定の寸法のグリッドに分けて使います。

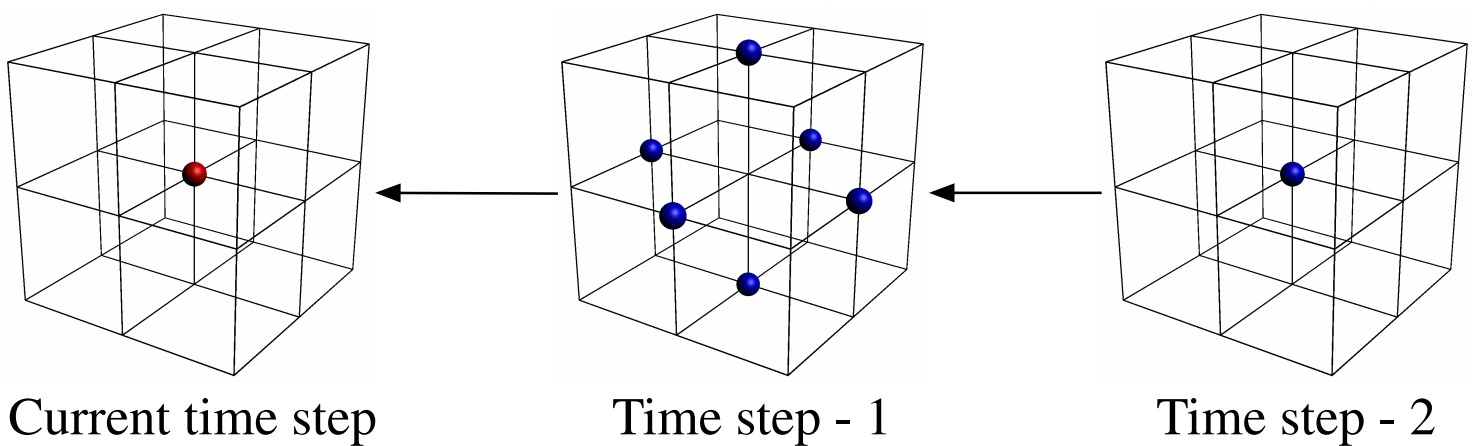

任意の点の音圧が、近未来に周囲の点に影響するという考えに基づいています。この単純な考えの下、伝達媒質に関する情報と高度な数学を組み合わせて、周辺の点の過去の値を使って任意の点の音圧値を計算できます。逆に言えば、音がどこにあったか分かれば、どこに行くかを予測できるということです。同時に、グリッド上の全ポイントの値をフレームごとに再計算する必要があります。例えば、耳に聞こえる帯域幅全体ではフレーム数が毎秒44,100です。グリッド寸法は、希望するサンプリングレートによって変えられます。実際に高周波をシミュレーションするには、短い音波の動作を正確にシミュレーションするのに必要なグリッド寸法が小さくなります。

FDTD法では、時間的・空間的に隣接する点を使って、1つの点の音圧を計算する

FDTD法で音源を再生するには、信号を必要なタイムフレーム数に合わせて、単純に特定の点をモデリングに設定します。一定時間のこの信号の振幅が、フレーム毎の音圧に変換されます。同様にして、音の信号を形成するために特定の場所で一定期間に渡り計算した音圧を基に、リスナーの位置を決めます。FDTDでは、リスナーの位置に関わらず、全ての点のそれぞれの音の振動を同時にシミュレーションします。

部屋の大きさや必要最低限の波長によって、演算処理に数分から数時間がかかります。それでは、リアルタイムでこの方式を使う方法はあるのか?インパルスをサウンドソースとして使用してIR(インパルスレスポンス)を生成して、オフラインでシミュレーションすることができます(コンボリューションリバーブに関する以前の記事を参照)。この処理で一連のIRが作成されるので、コンボリューションを通して後からリアルタイムで使えます。スペーシャルオーディオ目的のために高次アンビソニックスを生成できますが、事前に録音した部屋のIRと同様に、様々な音源とリスナーのポジションを表現するのに必要な保存容量が、現実的でなくなってしまいます。

高周波で正確な結果を出すにはグリッドの細かい目が必要になり、全ての聞き取れる周波数をシミュレーションするのに数ミリ程度の大きさなので、グリッドサイズを小さくすれば計算負荷を軽減できます。つまり低周波数の音伝播のシミュレーションに適した方式と言えます。サンプリングレートを下げれば、演算コストや保存容量を減らせます。普通は高周波が遠くに伝わるわけではないので、大気や壁面による吸音が重要な役割を担います。

波動ベースのシミュレーションは周波数に依存する音の回析のシミュレーションを複雑な室形状に基づいて行うのに適していて、これはレイベース法では対応できません。一般的に波動ベースの方式の方がエコー密度をより正確にシミュレーションするので、後期残響を生成するのに長けていると考えられます。とはいえ、全ての実空間が望ましいリバーブを生み出すわけではないのと同様に、メディア制作の観点からみて必ずしも素晴らしいといえる音にならないシミュレーションもあります。レンダリングに時間がかかるので、調整過程が手間どり、作業を妨害することもあります。

FDTD法のアプローチでは波伝播のシミュレーションで融通がききませんが、他の波動ベースの方式では一部の物理処理を簡素化して速いシミュレーションを提供します。このような理由で、実際のメリットやデメリットは方式によってまちまちです。

直接的なIRコンボリューション以外にも、生成されたデータの使い道はあります。例えば、音伝播を500 Hz以下の低周波シミュレーションとしてレンダリングすれば、処理結果を使って時間の経過とともにリバーブの振幅がディケイする様子を分析できます。次に、この情報を従来のリバーブアルゴリズムのパラメータに活用できます [6]。リバーブのパラメータ設定を自動化する効率的な方法であり、多数の部屋がある大がかりな仮想ワールドなどに便利です。このアプローチは、最近リリースされたGears of War 4向けのWwiseプラグインとして、Microsoftが実装しました。

以下の動画もBrian Hamiltonの提供で [4]、波動ベース法で音伝播をレンダリングした様子です。内角から複数の新しい波面が発生しているのが分かります。

波動ベース法の音伝播モデリング

|

|

|

|

|

この2つのシミュレーション [4] は、レイベースと波動ベースの音響シミュレーションの差を表します。

レイベース音響モデリング

波動ベース音響モデリング

では、この2つのうち、どちらが有力か?両方です!確かに複雑なシミュレーションでは波動ベースが良いように見えますが、レイベース方式も正しく使えば素晴らしい音を提供してくれます。音伝播は物理的に非常に複雑になりかねませんが、究極に簡素化しても満足できる音を得ることもできます。完全にシミュレーションする場合は必要な演算が膨大となりますが、知覚的にみて価値があるかどうかを判断する必要があります。面白いことに、レイベースと波動ベースの両方式が、お互いの短所を補完し合っているようです。例えばレイベース方式は「高周波」の「アーリーリフレクション」のシミュレーションに長けている一方、波動ベースのモデルは「低周波」「後期残響」「複雑な形状の回析エフェクト」に向いています。

次の記事では、従来のリバーブ方式、レイベース方式、波動ベース方式の3つを組み合わせて、インタラクティブな空間エフェクトに適した柔軟性と効率性を持ち合わせたハイブリッド型の様々なリバーブレーターを検証します。

バーチャル音響についてさらに詳しく知るには、インタラクティブなアニメーションでこれらのテクニックの一部を説明した、インタラクティブな教科書がお勧めです [8]。

インタラクティブ教科書 [8]

エジンバラ大学のAcoustics and Audioグループのウェブサイト [9] にも、波動ベース法のシミュレーションの興味深い情報や、部屋のモデル以外に楽器のモデル化に使う方法などを紹介しています。

参考文献:

[1] http://sat.qc.ca/en/albums/symposium-ix-2016#lg=1&slide=14

[2] http://sat.qc.ca/en/albums/symposium-ix-2016#lg=1&slide=17

[3] http://interactiveacoustics.info/html/GA_RT.html

[4] http://www.acoustics.ed.ac.uk/group-members/brian-hamilton/

[5] C. Webb, "Computing virtual acoustics using the 3D finite difference time domain method and Kepler architecture GPUs", In Proceedings of the Stockholm Music Acoustics Conference, pages 648-653, Stockholm, Sweden, July 2013.

[6] Nikunj Raghuvanshi and John Snyder. 2014. Parametric wave field coding for precomputed sound propagation. ACM Trans. Graph. 33, 4, Article 38 (July 2014), 11 pages. http://dx.doi.org/10.1145/2601097.2601184

[8] http://interactiveacoustics.info/

[9] http://www.ness.music.ed.ac.uk/

コメント